Retour à la table des matières

Revue Droits et libertés, printemps / été 2022

Renforcement de la vie privée et éthique du design numérique

Michelle Albert-Rochette, candidate à la maîtrise en droit, Université Laval

Marie-Pier Jolicoeur, candidate au doctorat en droit du design numérique, Université Laval

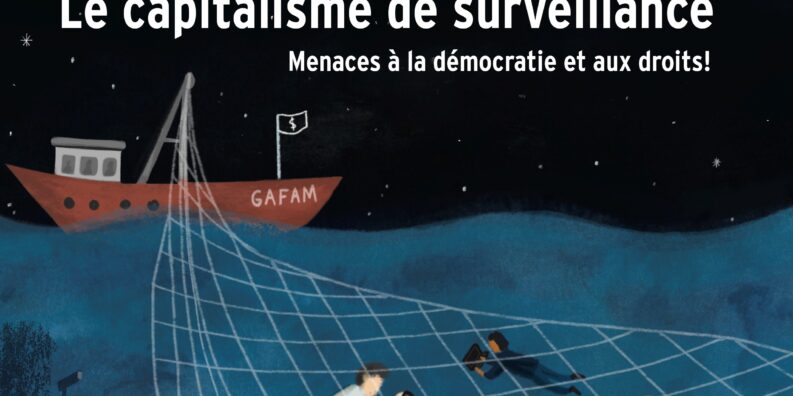

Shoshana Zuboff dénonce, dans son ouvrage The Age of Surveillance Capitalism, un modèle économique basé sur l’extraction de nos données personnelles1. Dans cette nouvelle forme de capitalisme, la professeure Zuboff expose que l’on cherche, de toutes les manières possibles et pour des motifs économiques, à ce que les personnes passent le plus de temps possible en ligne afin de générer toujours plus de données2. La collecte et le traitement d’une quantité massive de données permettent ultimement aux grandes entreprises de mieux prédire et contrôler le comportement des personnes3. Les outils technologiques et les médias sociaux que nous utilisons quotidiennement sont ainsi mis au service de l’addiction by design4, soit l’objectif de créer une propension à utiliser continuellement ces technologies. L’objet de ce court article n’est pas de proposer des pistes de solution révolutionnaires au modèle décrit par la professeure Zuboff, mais plutôt d’ouvrir les lectrices et lecteurs à de nouvelles perspectives. Nous décrirons donc certaines initiatives qui visent à créer un environnement numérique davantage respectueux de la vie privée et des vulnérabilités humaines. Nous présentons d’abord, dans une perspective critique, quelques propositions juridiques. Ensuite, nous proposons un court examen du thème de l’éthique du numérique.

Aperçu du projet de loi 64

Le projet de loi 645 (PL 64), adopté le 21 septembre 2021, a modifié la loi québécoise de protection des renseignements personnels6 (RP) dans le secteur privé. Un de ses objectifs est d’accroître le contrôle qu’ont les personnes sur leurs données. Les modifications introduites par PL 64 s’intéressent notamment aux pratiques de profilage en imposant de nouvelles obligations aux entreprises, qui devront désormais avertir les personnes et les informer des moyens dont elles disposent pour activer les fonctions de profilage7, comme la publicité ciblée. Le PL 64 a aussi introduit des exigences à l’obtention du consentement pour la collecte, l’utilisation ou la communication de RP8. Le but est de mieux informer les personnes pour les protéger en leur permettant de faire des choix éclairés. Ces modifications paraissent positives, mais on peut douter de leur utilité : même si le consentement est renforcé par l’introduction de nouvelles normes, ce mécanisme demeure ancré dans une vision individualiste de la vie privée peu adaptée au fonctionnement du capitalisme de surveillance.

En effet, à l’ère du numérique, il est peu praticable de refuser son consentement. On peut par exemple penser à la nécessité d’accepter les politiques de confidentialité de Facebook pour accéder à différents services et pour entretenir des liens sociaux9. Le mécanisme de consentement individuel occulte par ailleurs les effets systémiques liés au traitement des données. Au moment de consentir, on peut difficilement imaginer ce que ses données peuvent révéler sur soi lorsqu’elles sont croisées avec des milliards d’autres10. On ne peut non plus appréhender le pouvoir que confère aux entreprises le cumul de données d’apparence anodine11. Et même si un consentement était réellement libre et éclairé, ce choix individuel a des effets collectifs puisqu’il permet d’inférer des informations sur les autres : « [b]y consenting […] a user becomes a conduit for gathering information about her entire social network, whether or not they have consented12».

Le mécanisme de consentement individuel occulte par ailleurs les effets systémiques liés au traitement des données.

Vers des solutions collectives

Face à ces limites, des autrices et auteurs ont envisagé des solutions qui s’écartent de la perspective dominante de contrôle individuel des données, parmi lesquelles figurent les fiducies de données13 – qui consistent en une mise en commun de données gérées par un tiers indépendant agissant pour le compte des personnes – et le devoir de loyauté (duty of loyalty 14). Cette deuxième solution cherche à garantir que les entreprises qui collectent et traitent les données agissent conformément à la confiance que les personnes leur accordent. Un réseau social assujetti à une telle obligation devrait donc agir selon les attentes raisonnables des personnes relativement à l’utilisation de leurs données et à leur expérience en ligne15. Ainsi, l’utilisation des données à des fins de publicité contextuelle serait loyale, mais pas celle réalisée à des fins de publicité comportementale. Par exemple, une personne consultant un site de voyage sur un pays donné pourrait s’attendre à recevoir de la publicité en lien avec ce pays, mais il serait déloyal pour une entreprise de diffuser une publicité basée sur le traitement de nombreux types de données issues de sources variées16. En matière d’expérience en ligne, le devoir de loyauté pourrait aussi inclure une exigence d’influence loyale17, où les entreprises ne pourraient pas concevoir un design visant à manipuler le comportement des personnes à l’encontre de leurs intérêts. L’imposition d’un tel devoir de loyauté aurait pour avantage de protéger les personnes indépendamment de leur niveau de compréhension des politiques de confidentialité18.

Pour une éthique du numérique

Dans un article de 2018 s’intéressant au capitalisme de surveillance et visant à mettre en lumière le processus par lequel l’IA parvient à collecter nos données personnelles, le professeur Pierre-Luc Déziel émettait certaines réserves sur la capacité de la législation canadienne à protéger à elle seule notre vie privée :

Au cours des dernières années, de nouveaux droits visant la protection de la vie privée informationnelle des personnes firent leur apparition : droit à l’explication, droit à la portabilité des données et le fameux droit à l’oubli. Ces droits […] pourraient aider les personnes à mieux protéger leur vie privée dans les environnements numériques. Toutefois, je crois que, pour répondre aux défis soulevés […], le droit à la vie privée ne peut agir seul, et que d’autres pans du droit peuvent et doivent être mobilisés19.

Pour compléter ce court article, il nous apparaît intéressant de nous ouvrir aux enjeux entourant l’éthique du numérique. Pour les programmeuses et programmeurs informatiques, réfléchir à ce qu’est un bon code informatique est fondamental20, mais cette question ne se limite plus seulement à la création d’outils efficaces et performants. De nouveaux concepts comme celui de Privacy by design, Safety by design et Éthique by design, qui répondent à des questions morales et de devoir- être de l’objet technique21, ont vu le jour. La PhD Flora Fisher explique que la prolifération des termes by design dans les dernières décennies révèle l’existence de nouveaux concepts polysémiques obligeant à entamer une réflexion sur l’éthique virtuelle et sa puissance normative22. Très sommairement, l’idée serait, dans le cas de la vie privée, de tenir compte dès la phase de conception des systèmes informatiques, des exigences en matière de protection des données personnelles en les intégrant directement dans le produit, au lieu de les ajouter ultérieurement23. On chercherait donc à limiter, a priori, la divulgation de données collectées24. Pour Lawrence Lessig, professeur de droit à Harvard, le code informatique a une force équivalente à celle de la loi puisque le design du numérique impose de produire certains comportements. Ce code constitue également un levier important pour protéger les droits de ces utilisatrices et utilisateurs25. En somme, s’il l’on veut réellement avoir un impact pour améliorer les choses à long terme, c’est à l’architecture même du code informatique, au design du numérique, qu’il faudra s’intéresser, pour éviter que les solutions avancées soient de simples coups d’épée dans l’eau.

Très sommairement, l’idée serait, dans le cas de la vie privée, de tenir compte dès la phase de conception des systèmes informatiques, des exigences en matière de protection des données personnelles en les intégrant directement dans le produit, au lieu de les ajouter ultérieurement.

- S. Zuboff, The Age of Surveillance Capitalism. The Fight for a Human Future at the New Frontier of Power, PublicAffairs, New York, 2019.

- Id.

- N. Richards et W. Hartzog, A Duty of Loyalty for Privacy Law, 2021, 99 Wash.U. L. Rev. 961, p. 18

- N. D. Schüll, Addiction by design, Princeton University Press, 2012.

- Loi modernisant des dispositions législatives en matière de protection des renseignements personnels (Loi modernisant la loi sur le privé).

- Loi sur la protection des renseignements personnels dans le secteur privé.

- Loi modernisant la loi sur le privé, 8.1.

- Id, 14.

- Jack Balkin,The Fiduciary Model of Privac, 2020, 134:1 HLRF 11, p. 13.

- J. A.T. Fairfield et C. Engel, Privacy as a Public Goo, 2015, 65:3 Duke L.J. 385, p. 390.

- Ex: S. Delacroix et N. D. Lawrence, Bottom-up data Trusts: disturbing the ‘one size fits all’ approach to data governance, 2019, 9:4 Int. Data Priv. Law 236, p. 237.

- A.T. Fairfield et C. Engel, supra note 10, p. 410.

- Ex : Delacroix et N. D. Lawrence, supra note 11.

- N. Richards et W. Hartzog, A Duty of Loyalty for Privacy Law, supra note 3.

- N. Richards et W. Hartzog, The Surprising Virtues of Data Loyalty, 71 ELJ (à paraître 2022), p. 8.

- Jack Balkin, supra note 10, p. 28.

- N. Richards et W. Hartzog, supra note 15, p.44.

- N. Richards et W. Hartzog, supra note 15, p. 27.

- P-L. Déziel, Les limites du droit à la vie privée à l’ère de l’intelligence artifici- elle : groupes algorithmiques, contrôle individuel et cycle de traitement de l’information, 2018, 30:3 C.P.I. 827.